【0基础秒入门】OpenAI CLIP模型深度解析:多模态视觉语言模型的原理与应用

OpenAI CLIP模型深度解析:多模态视觉语言模型的原理与应用去发现同类优质开源项目:https://gitcode.com/一、CLIP模型概述OpenAI推出的CLIP(Contrastive Language-Image Pre-training)是一种革命性的多模态模型,它通过对比学习的方式将视觉和语言两个模态的信息映射到同一语义空间。这种创新架构使得模型能够理解图像内容与自然语...

OpenAI CLIP模型深度解析:多模态视觉语言模型的原理与应用

去发现同类优质开源项目:https://gitcode.com/

一、CLIP模型概述

OpenAI推出的CLIP(Contrastive Language-Image Pre-training)是一种革命性的多模态模型,它通过对比学习的方式将视觉和语言两个模态的信息映射到同一语义空间。这种创新架构使得模型能够理解图像内容与自然语言描述之间的深层关联。

二、模型技术细节

2.1 核心架构

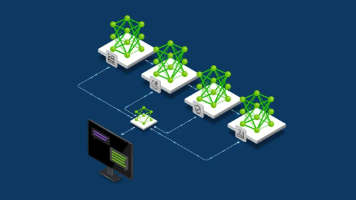

CLIP采用双编码器设计:

- 图像编码器:基础版本采用改进的ResNet50架构,后续版本引入了Vision Transformer(ViT)变体

- 文本编码器:基于掩码自注意力机制的Transformer架构

两个编码器通过对比损失函数进行联合训练,目标是最大化匹配的图像-文本对的相似度,同时最小化不匹配对的相似度。

2.2 模型版本演进

CLIP模型系列经历了多个版本的迭代:

-

初始版本(2021年1月):

- RN50(基于ResNet50)

- ViT-B/32(基于Vision Transformer)

-

后续扩展版本:

- RN101(更深的ResNet架构)

- RN50x4(按EfficientNet规则扩展4倍的ResNet)

- ViT-B/16(更高分辨率的ViT变体)

- RN50x64(大规模扩展的ResNet)

- ViT-L/14@336px(目前最高性能的ViT变体)

三、模型训练与数据

3.1 训练数据来源

CLIP的训练数据主要来自:

- 公开可用的图像-标题数据集(如YFCC100M)

- 从多个网站爬取的图像-文本对

- 过滤机制确保排除不当内容

3.2 数据代表性

需要注意的是,训练数据主要反映互联网活跃群体的特征,存在以下偏差:

- 偏向发达国家用户

- 年龄分布偏向年轻群体

- 性别比例偏向男性用户

四、模型能力与局限

4.1 性能表现

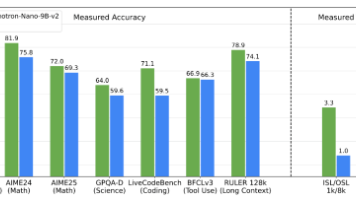

CLIP在30+个计算机视觉基准测试中展现出强大的零样本(zero-shot)迁移能力,包括:

- 通用图像分类(ImageNet)

- 细粒度分类(Stanford Cars)

- 场景识别(SUN397)

- 特殊任务(OCR、物体计数等)

4.2 主要局限性

-

技术局限:

- 细粒度分类准确率有待提升

- 物体计数能力较弱

- 线性探测评估可能低估真实性能

-

公平性问题:

- 不同人口统计群体的表现差异

- 种族分类准确率约93%

- 年龄分类准确率约63%

- 可能强化现有社会偏见

五、应用场景与注意事项

5.1 适用场景

CLIP主要面向研究用途:

- 多模态表示学习研究

- 零样本学习机制探索

- 模型鲁棒性分析

- 跨学科AI影响研究

5.2 使用限制

严格不建议以下应用场景:

- 任何未经充分测试的部署应用

- 监控和人脸识别系统

- 非英语语言场景

- 商业产品直接集成

六、伦理考量

使用CLIP时需要特别注意:

- 类别设计会显著影响模型表现和偏差

- 不同人口群体可能存在性能差异

- 需要针对具体应用场景进行全面的公平性测试

- 避免强化有害的社会刻板印象

七、最佳实践建议

对于希望使用CLIP的研究人员:

- 充分理解模型的技术局限

- 针对特定任务进行全面的评估

- 建立适当的偏差检测机制

- 考虑模型决策的潜在社会影响

- 保持研究过程的透明度和可重复性

CLIP代表了多模态学习的重要突破,但其强大的能力也伴随着相应的责任。研究人员应当以审慎和批判性的态度使用这类先进模型,推动AI技术向更负责任的方向发展。

去发现同类优质开源项目:https://gitcode.com/

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)