毕业设计-基于深度学习的社交媒体谣言识别系统 python 人工智能

毕业设计:基于深度学习的社交媒体谣言识别系统。通过深度学习和自然语言处理技术的结合,我们提出了一种创新的方法来识别社交媒体上的虚假信息。本研究为计算机毕业设计提供了一个有意义且具有挑战性的研究课题,结合了深度学习和计算机视觉技术。对于计算机专业、软件工程专业、人工智能专业和大数据专业的毕业生而言,这个课题能够为他们提供一个具有创新性的研究方向。不论您对深度学习技术保持浓厚兴趣,还是希望探索机器学习

目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于深度学习的社交媒体谣言识别系统

设计思路

一、课题背景与意义

在当今社交媒体时代,虚假信息和谣言的传播日益猖獗,给社会带来了严重的影响。社交媒体平台成为了虚假信息和谣言传播的主要渠道之一,其迅速传播的特点使得虚假信息和谣言更加具有危害性和影响力。社交媒体平台作为虚假信息和谣言传播的主要渠道,有责任管理和监控平台上的信息内容。谣言识别系统可以为社交媒体平台提供一种自动化的工具,帮助平台快速识别和处理虚假信息,提高平台的管理能力和用户体验。

二、算法理论原理

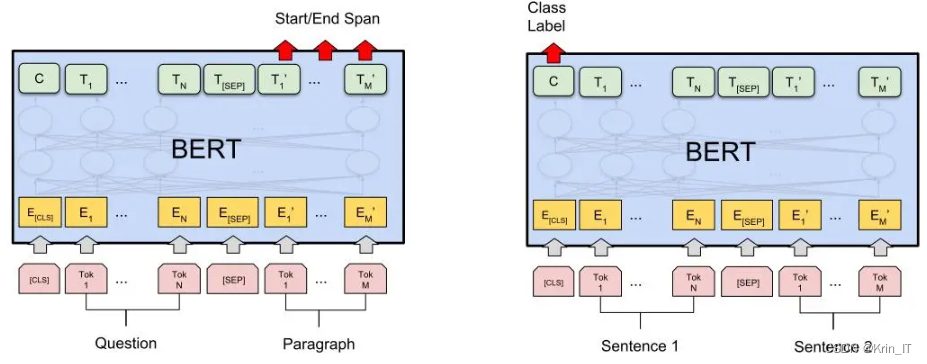

2.1 BERT模型

BERT是一种基于Transformer模型的预训练语言表示模型,BERT的主要目标是通过预训练和微调的方式,在各种自然语言处理(NLP)任务上取得优秀的性能。它在多个任务上取得了顶级水平的性能,如文本分类、命名实体识别、情感分析、问答系统等。由于BERT模型具有强大的语言表示能力和广泛的应用价值,它成为了NLP研究和应用中的重要工具和基础模型。

它的关键特点包括双向性、预训练、微调和多层表示。通过双向Transformer结构,BERT能够同时考虑上下文信息,更好地捕捉词语之间的关系和语义。预训练阶段通过掩码语言建模和下一句预测任务,学习到了丰富的语言表示和上下文关系建模能力。微调阶段将预训练的模型应用于具体NLP任务,并通过任务特定的输入和训练来调整模型参数以适应任务要求。多层表示结构使得BERT能够从不同层次上捕捉到不同粒度的语义信息。

2.1 循环神经网络

LSTM是一种循环神经网络(RNN)的变体,旨在解决传统RNN中的长期依赖问题和梯度消失/爆炸问题。传统RNN在处理长序列时容易出现梯度消失或梯度爆炸的情况,导致难以捕捉到序列中的长期依赖关系。LSTM通过引入门控机制,有效地解决了这些问题。LSTM单元包含一个细胞状态和三个门:遗忘门、输入门和输出门。遗忘门决定了前一状态的哪些信息应该被遗忘,输入门决定了当前状态应该接收哪些新信息,输出门决定了当前状态的输出。BiLSTM是在LSTM的基础上引入了双向结构。通过使用两个LSTM,一个按照正序处理输入序列,另一个按照逆序处理输入序列。这样,每个时间步的输出是由前后两个方向的信息共同决定,从而更全面地捕捉到序列中的上下文信息。BiLSTM在处理序列任务时特别有用,因为它能够同时考虑到过去和未来的信息,对于某些任务(如命名实体识别)中的上下文理解非常重要。

BiLSTM是一种具有双向结构的循环神经网络,由两个LSTM组成。它的关键特点包括双向结构、LSTM单元、序列建模和特征表示学习。通过双向结构,BiLSTM能够同时考虑前后两个方向的信息,捕捉到序列中的上下文信息。LSTM单元通过门控机制控制信息的流动,记忆和遗忘特定的信息,解决了传统RNN中的梯度问题。BiLSTM适用于处理序列数据,并在各种NLP任务中应用广泛,能够有效地捕捉到序列的语法、语义和上下文信息。同时,BiLSTM可以学习输入序列的高级语义表示,这些表示可用于后续的特征提取和模式识别任务。通过在训练数据上进行端到端的学习,BiLSTM能够自动提取输入序列中的有用特征。

三、算法实现

3.1 数据集

为了构建可靠的社交媒体谣言识别系统,我们需要一个合适的数据集。由于网络上没有现有的合适数据集可用,我们决定自己进行数据集构建。我们使用网络爬虫工具收集了大量社交媒体上的帖子、评论和转发等信息,并进行了人工标注,将它们标记为谣言或非谣言。通过这个自制的数据集,我们能够提供更准确、可靠的数据,为社交媒体谣言识别系统的研究和开发提供有力的支持。

3.2 模型训练

社交媒体谣言识别系统的设计思路如下:

- 数据预处理:首先,对收集到的社交媒体数据进行预处理,包括文本清洗、分词和去除停用词等步骤。这样可以减少噪声和冗余信息,提取出有效的特征。

- 特征表示:利用预训练的Bert模型,将清洗后的文本转换为语义丰富的向量表示。Bert模型能够捕捉到上下文信息和语义关联,对于虚假信息识别非常有帮助。

- 混合模型构建:将Bert的输出作为BiLSTM模型的输入,BiLSTM模型能够有效地捕捉文本的时序信息。通过双向LSTM的结构,我们可以获得每个时间步的隐藏状态表示。

- 特征融合与分类:将Bert和BiLSTM的隐藏状态进行特征融合,可以通过简单的拼接或加权求和等方式实现。融合后的特征输入到全连接层进行分类,判断文本是否为虚假信息。

- 模型训练与优化:使用标注好的数据集对混合模型进行训练,并通过反向传播算法更新模型参数。可以采用交叉熵损失函数作为优化目标,并结合优化算法如Adam进行模型参数的优化调整。

- 模型评估与调优:使用测试集对训练好的模型进行评估,计算准确率、召回率、F1值等指标来评估模型的性能。根据评估结果,可以进行模型的调优,如调整超参数、增加训练数据量等,以提高模型的性能。

相关代码示例:

class BertBiLSTM(nn.Module):

def __init__(self, bert_config, lstm_hidden_size, num_labels):

super(BertBiLSTM, self).__init__()

self.bert = BertModel.from_pretrained(bert_config)

self.lstm = nn.LSTM(bert_config.hidden_size, lstm_hidden_size, bidirectional=True, batch_first=True)

self.dropout = nn.Dropout(0.1)

self.fc = nn.Linear(lstm_hidden_size * 2, num_labels)

def forward(self, input_ids, attention_mask):

bert_output = self.bert(input_ids=input_ids, attention_mask=attention_mask)[0]

lstm_output, _ = self.lstm(bert_output)

lstm_output = self.dropout(lstm_output)

logits = self.fc(lstm_output[:, -1, :]) # 使用最后一个时间步的输出进行分类

return logits

# 定义模型参数

bert_config = 'bert-base-uncased'

lstm_hidden_size = 128

num_labels = 2 # 二分类,虚假信息和非虚假信息

# 创建模型实例

model = BertBiLSTM(bert_config, lstm_hidden_size, num_labels)

# 加载预训练的模型参数

model.load_state_dict(torch.load('model.pth'))

model.eval()

# 定义tokenizer

tokenizer = BertTokenizer.from_pretrained(bert_config)创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

最后

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)