毕业设计:基于深度学习的电影情感分析与个性化推荐系统 人工智能

毕业设计:基于深度学习的电影情感分析与个性化推荐系统结合了深度学习和计算机视觉技术,能够自动分析电影中的情感内容,并根据用户的个性化偏好进行推荐。通过对大量电影数据进行深度学习模型的训练和优化,系统能够准确地分析电影中的情感要素,并根据用户的喜好进行个性化推荐。该系统为用户提供了更精准、个性化的电影推荐,帮助用户发现符合自己情感需求和喜好的电影作品。结合了深度学习和计算机视觉技术,能够自动分析电影

目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于深度学习的电影情感分析与个性化推荐系统

设计思路

一、课题背景与意义

电影作为一种重要的文化媒介,对人们的情感和观影体验有着深远的影响。为了提供更好的电影推荐和个性化观影体验,电影情感分析与个性化推荐系统应运而生。能够自动识别和分析电影中的情感内容,并根据用户的个性化偏好进行推荐。通过深入理解用户的情感需求和喜好,系统能够为用户提供更准确、个性化的电影推荐,提升用户的观影体验和满意度。

二、算法理论原理

2.1 深度学习

LSTM是在RNN基础上增加了中间状态信息的一种循环神经网络模型。其主要特点是通过遗忘门来选择性地遗忘一些不太重要的信息,从而增强模型在处理长序列训练任务上的效果。LSTM由遗忘门、输入门和输出门三个门控单元组成。遗忘门用于计算需要遗忘的信息,输入门用于计算需要更新的数据,输出门则决定输出信息。通过这些门控机制,LSTM可以有效地控制信息的流动和存储,从而解决了传统RNN在处理长序列时容易出现梯度消失或梯度爆炸的问题。LSTM的计算公式包括遗忘门的计算、输入门的计算、输出门的计算以及单元状态信息的遗忘和更新。最后,通过计算隐藏层输出得到最终的结果。LSTM通过引入遗忘门、输入门和输出门的机制,以及单元状态信息的管理,能够在处理长序列训练任务时展现出更好的效果。它的设计使得模型能够更好地处理和记忆长期依赖关系,提高了循环神经网络在各种序列建模任务中的表现。

GRU模型是在LSTM基础上进行了简化和改进的循环神经网络模型。通过引入更新门和重置门,并结合候选激活状态和激活状态的计算,GRU能够在处理长序列任务时表现出良好的效果,同时具有更简单的结构和参数。

GRU在LSTM的基础上进行了两个主要改进:一是取消了LSTM的遗忘门和输入门,引入了更新门;二是将控制参数和输出相结合,产生具有LSTM功能的输出。此外,GRU还进行了其他一些小的改动,例如混合单元状态和隐藏状态。GRU模型包含两个门控单元:更新门和重置门。更新门决定前一个时刻的输出在当前状态中保留的比例,更新门的值越大,表示保留的内容越多。重置门决定如何将当前状态与前一状态相结合,控制前一状态对当前候选激活状态的影响程度,重置门的值越小,表示前一状态被保留的越少。

2.2 语言模型

XLNet模型是在BERT基础上进行改进的。与AR不同,XLNet不使用固定的因式分解顺序,而是通过最大化所有因式分解顺序的期望对数似然值来训练模型。这种改进使得XLNet能够更好地捕捉双向上下文信息。另一个改进是XLNet不依赖于残缺数据。在BERT中,由于掩盖了一部分输入数据进行预训练,导致预训练和微调阶段的数据不一致。而XLNet通过不依赖残缺数据的方式解决了这个问题,确保了预训练和微调阶段的数据一致性。

XLNet模型的核心思想是通过排列组合的方式重构输入文本,将一部分下文内容放到上文中,从而充分利用上下文信息实现双向预测的功能。然而,在微调阶段无法对原始输入文本进行排列组合,因此在预训练阶段,XLNet通过Attention掩码的方式在Transformer内部改变输入文本的顺序来实现这一功能。

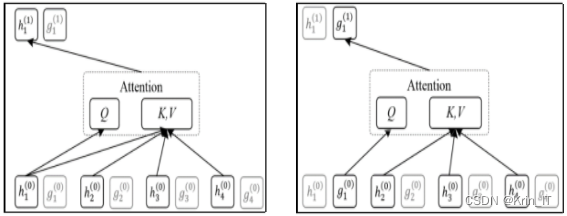

双流注意力机制是一种能够处理双输入序列的注意力机制,用于实现信息的交互和融合。它通过映射输入序列到查询向量和键值对,并计算它们之间的相关性来获得注意力权重。通过归一化注意力权重并对键值序列进行加权求和,最终得到查询序列对键值序列的加权表示。这个过程包括输入表示、相关性计算、注意力权重归一化、加权求和和输出计算等步骤。双流注意力机制在自然语言处理和机器学习任务中具有广泛的应用,为提高模型性能和信息交互能力提供了有效的工具。

XLNet模型中的Content掩码矩阵和Query掩码矩阵用于处理双流注意力机制。在Content掩码矩阵中,每个位置的词可以利用排列后位置之前的词的信息。例如,第一个词可以利用所有词的信息,第二个词可以利用第二个词和第三个词的信息,依此类推。Query掩码矩阵则不允许词利用本身的信息,因此对角线上的位置是白点表示掩码。

循环机制是XLNet模型的另一个关键部分,它受到Transformer-XL模型的启发。循环机制通过将前一个单词的隐藏层信息用于下一个单词的计算,从而获得更长距离的上下文信息。这种循环结构能够在处理长文档相关任务时发挥良好的效果,提供更丰富的上下文信息。

三、检测的实现

3.1 数据集

验数据的获取是通过爬虫技术从豆瓣电影网站上进行的。爬虫的实现使用了Python编程语言、PyCharm工具、Requests库和BeautifulSoup库等工具。Requests库是一个方便的HTTP库,用于发送网页请求。BeautifulSoup库则用于解析网页数据,从中抓取所需的信息,并进行编码转换。在实施爬虫之前,首先需要获取电影的所有类型。然后,将类型标签进行URL编码,并将其拼接到豆瓣的URL链接中,以获取所有电影的URL。通过爬取这些URL,可以获取电影的详细信息和评论信息等。

电影详细信息的爬取大致流程如下:首先使用requests库发送HTTP请求,通过get方法提供URL参数和设置HTTP请求的头部参数,包括用户代理和编码方式等。然后,使用BeautifulSoup库对返回的网页进行解析。在解析之前,可以通过浏览器的开发者模式查看要爬取数据的属性名、标签结构和类名等信息,以便准确定位所需的数据。通过解析网页的HTML结构,可以提取出所需的电影详细信息,例如电影名称、导演、演员、评分等。这些信息可以根据其在HTML中的位置、标签属性和类名等特征进行定位和提取。总之,通过使用requests库发送请求获取网页内容,并利用BeautifulSoup库解析网页,可以方便地提取出电影详细信息。这种爬取数据的流程需要结合

爬取电影详细信息的流程包括定位所需字段的HTML标签和类名,利用BeautifulSoup库的方法提取相应字段的内容。为了应对豆瓣的反爬虫技术,需要设置伪装头部、切换用户代理和使用IP代理池等技术手段。这些操作可以提高数据爬取效率并避免被封禁IP。

3.2 实验环境搭建

在Windows 10操作系统下,使用Python编程语言,通过Keras库和pytorch_transformers库实现了BiLSTM和XLNet网络。Keras库提供了高层API,底层基于TensorFlow框架实现,用于快速搭建和训练神经网络模型。通过Keras库,可以方便地定义网络的层结构、损失函数和优化器,以及进行模型的训练和评估。

3.3 实验及结果分析

使用爬虫技术搜集了豆瓣网中的电影以及评论,进行数据清洗。由于中间星级的评论数据可能存在模糊的问题,会降低模型的训练效果,选择取1星和5星两端的评论数据作为正负极评论。对于情感分析模型的训练,使用了XLNet语言模型自带的SentencePiece分词技术,不需要额外的分词技术。然而,在进行Word2Vec相关的对比实验时,需要对评论数据进行去停用词和分词处理。

Word2Vec模型用于解决分词序列在one-hot编码后数据过于稀疏的问题。它通过学习每个词组的嵌入向量,将一条语句转化为向量的表达形式。在数据处理上,工作包括搜集去停用词词库和情感词词库,并导入自定义的词典。使用jieba分词的精确模式对评论数据进行分词,并去除停用词。自定义的词典综合了jieba原词典、知网中文情感词典和台湾大学简体中文情感词典。根据分词结果,生成词云图来了解分词词库中的高频词汇。

在进行情感分析模型的数据处理过程中,首先对评论数据进行了去噪处理,包括去除无效评论、转换繁体为简体、去除无用字符和删除过短的评论。然后,进行了分词处理,并统计了分词后的句子长度分布,确定了模型输入数据的句长参数为64。接下来,使用Tokenizer创建字典,将评论数据序列化为数字序列,并采用截长补短的方式统一句长。然后,下载并使用基于百度百科语料训练的Word2Vec预训练语言模型,选择了Skip-Gram训练模型,并加载了预训练模型。根据评论序列化结果,建立数字序列与词向量的映射关系,生成了嵌入层权重矩阵作为词向量输入。

相关代码示例:

from gensim.models import KeyedVectors

import numpy as np

# 加载Word2Vec预训练语言模型

word2vec_model = KeyedVectors.load_word2vec_format('path_to_word2vec_model.bin', binary=True)

# 获取词向量的维度

embedding_dim = word2vec_model.vector_size

# 获取评论序列化结果

serialized_comments = [...] # 评论序列化结果,示例:[[1, 5, 10, 3], [2, 7, 4, 6, 9], ...]

# 生成嵌入层权重矩阵

embedding_matrix = np.zeros((len(word2vec_model.vocab) + 1, embedding_dim))

for word, index in word2vec_model.vocab.items():

if word in serialized_comments: # 仅处理评论中出现的词语

embedding_matrix[index] = word2vec_model[word]

# 将嵌入层权重矩阵作为后续模型训练的词向量

# 在模型中使用embedding_matrix作为词向量的初始权重矩阵实现效果图样例:

创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

最后

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)